Background

마르코프 연쇄

확률론에서, 마르코프 연쇄(Марков連鎖, 영어: Markov chain)는 이산 시간 확률 과정이다. 마르코프 연쇄는 시간에 따른 계의 상태의 변화를 나타낸다. 매 시간마다 계는 상태를 바꾸거나 같은 상태를 유지한다. 상태의 변화를 전이라 한다. 마르코프 성질은 과거와 현재 상태가 주어졌을 때의 미래 상태의 조건부 확률 분포가 과거 상태와는 독립적으로 현재 상태에 의해서만 결정된다는 것을 뜻한다

제한적 볼츠만 머신

에너지 개념을 이용한 확률 표현

통계 물리학

• 동일한 상태에 있는 물질이라도 다양한 미시적 상태(micro state)에 있 을 수 있음

• 높은 에너지의 미시적 상태의 있을 확률은 낮음

• 낮은 에너지의 미시적 상태에 있을 확률은 높음

확률 그래프 모델

• 물질이 특정 형상(configuration)의 상태에 있을 확률 표현 가능 – 형상: 노드(확률변수)들에 허용되는 값의 조합

– 특정 형상에 해당하는 미시적 상태에 대한 에너지 정의

– 형상의 집합 : {𝒔1, 𝒔2, … , 𝒔𝑁} – 에너지의 집합 : {𝝐1, 𝝐2, … , 𝝐𝑁} • 물질이 형상 𝒔𝑖에 있을 확률 𝑝(𝒔𝑖) 정의

• 에너지 𝜖𝑖가 줄어들 수록 확률 값은 증가

Adversarial nets

Ex∼pdata(x) [log D(x)]

training data(real data) Discriminator에 넣었을 때 나오는 결과를 log 를 취했을 때 얻는 기댓값을

의미합니다.

Ez∼pz(z) [log(1 − D(G(z)))].

noise distribution(fake data) z= Generator에 넣었을 때 나오는 결과값(fake image)을

Discriminator에 넣었을 때 그 결과를 log(1 - 결과)를 했을 때 얻는 기댓값을 의미합니다.

Figure 1: Generative adversarial nets are trained by simultaneously updating the discriminative distribution (D, blue, dashed line)

discriminates between samples from the data generating distribution (black, dotted line)

px from those of the generative distribution pg (G) (green, solid line).

The lower horizontal line is the domain from which z is sampled, in this case uniformly.

The horizontal line above is part of the domain of x.

The upward arrows show how the mapping x = G(z) imposes the non-uniform distribution pg on transformed samples. G contracts in regions of high density and expands in regions of low density of pg.

(a) Consider an adversarial pair near convergence: pg is similar to pdata and D is a partially accurate classifier.

(b) In the inner loop of the algorithm D is trained to discriminate samples from data, converging to D∗(x) = pdata(x) pdata(x)+pg(x).

(c) After an update to G, gradient of D has guided G(z) to flow to regions that are more likely to be classified as data.

(d) After several steps of training, if G and D have enough capacity, they will reach a point at which both cannot improve because pg = pdata. The discriminator is unable to differentiate between the two distributions, i.e. D(x) = 1/2

TheoreticalResults

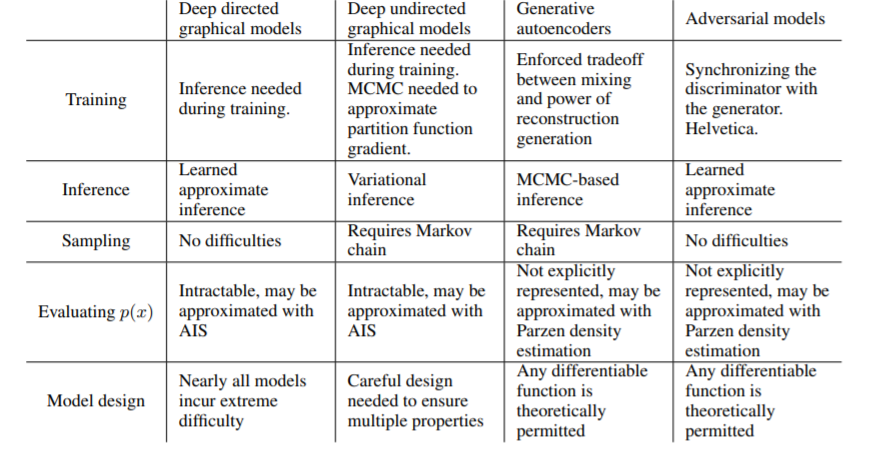

Advantages and disadvantages

단점은 주로 pg(x)의 명시적 표현이 없고, 훈련 중에 D가 G와 잘 동기화되어야 한다는 것이다(특히 G는 D를 업그레이드하지 않고 지나치게 훈련되어서는 안 된다.

마르코프 체인은 절대 필요하지 않고, 백프로프만 사용하여 그라데이션 획득, 학습 중 추론이 필요 없으며, 다양한 기능을 모델에 통합할 수 있다는 장점이 있다.

전술한 이점은 주로 계산이다. 적대적 모델은 또한 발전기 네트워크가 데이터 예제로 직접 업데이트되지 않고 차별자를 통해 도출되는 경사도에서만 약간의 통계적 이점을 얻을 수 있다. 이것은 입력의 구성 요소가 발전기의 파라미터에 직접 복사되지 않는다는 것을 의미한다. 적대적 네트워크의 또 다른 장점은 매우 날카롭고 심지어 퇴보적인 분포를 나타낼 수 있다는 것이다. 반면에 마르코프 체인에 기초한 방법들은 체인들이 모드들 간에 혼합될 수 있도록 분포를 다소 흐리게 할 것을 요구한다.